《Temporal Interlacing Network》笔记

summary

type

status

slug

category

date

tags

icon

password

comment

SLUGS

Source

authors: Shao Hao, Shengju Qian and Yu Liu

from:AAAI2020

Abstract

作者思考:能否将时间信息嵌入到空间信息中,使网络能一次性的学习两个域上的信息

Introduction

视觉行为从2D图像空间发展到3D空间(多了时间维度),增加了行为表达和识别任务的复杂度;并且速度和精度要求逐渐提高。

作者调研的视频理解分三阶段:

- 深度学习之前的时代:基于手工特征的时间特征表示(如光流)

- 深度学习时代:神经网络为特征提取器(包含LSTM,C3D,R(2+1)D,TSM),带来另一问题,模型参数和FLOPs更大

- 作者提出的方法:在时间维度上交错空间特征,将时间信息融合到空间特征中。保持更少的参数和FLOPs。

Related Work

- 视频理解:

- CNN在静态图像上有所建树,但在多了时间维度的视频上却是计算量庞大的

- 在深度学习之前用手工特征(HOG3D,SIFT-3D,iDT等)对vid进行分类

- 在进入深度学习时代,提出的双流以及后来的TSN网络,在不依赖时间关系的数据集(K600,UCF101,HMDB51)上分类效果好,而在依赖时间关系的数据集(Something-something,jester)上分类效果差

- 本质上2D CNN对视频分类任务还是静态图像的分类

- 可变形的时间建模:

- 最近工作中的可变卷积关注于空间变形(如DCNv1),大大提高了语义分割和物体检测性能

- Spatial Transformer Network使用全局仿射变换来学习具有平移不变性和旋转不变性的特征表示

- TSM基于TSN在时间维度shift特征图,但只能以固定位移shift(移位一格),并且不能适应帧数不均的视频,不够灵活

- 作者受到可变卷积的灵感,提出了一种能适应特定数据集和提取帧分布的可变移位算法

- self-attention:视频分类中使用自注意力机制带来效果提升

Temporal Interlacing Network

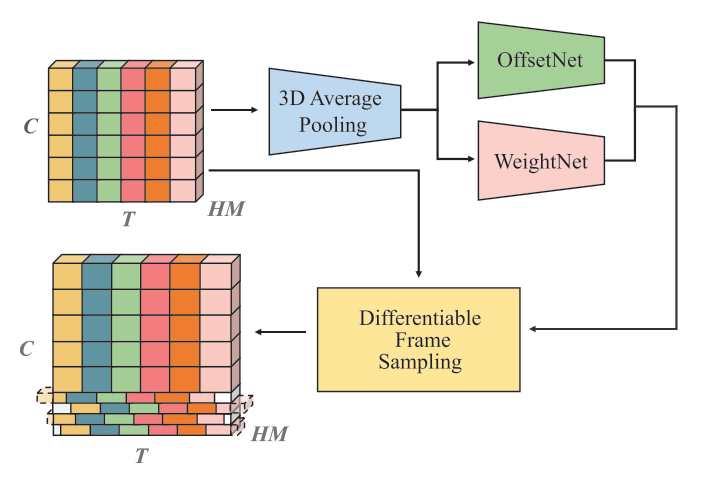

TIN分为两个模块:Deformable shift module和differentiable temporal-wise frame sampling

作者通过插入TIN到残差块的conv前来融合时间信息:

将输入 变化到

Deformable Shift Module

在该模块,主要任务是分别用OffsetNet和WeightNet计算得到偏移量和权重

- 在送入OffsetNet和WeightNet前,先平均池化:

- OffsetNet:

- 生成raw offset:

- 缩放到:

,,为channels的组数

- WeightNet:

- 卷积层(1D卷积层的kernel size为3,kernel数量等于group数量)

- sigmoid and rescale module(输出rescale到(0,2))

- 初始卷积层bias:0,初始output:1.0

Differentiable Temporal-wise Frame Sampling

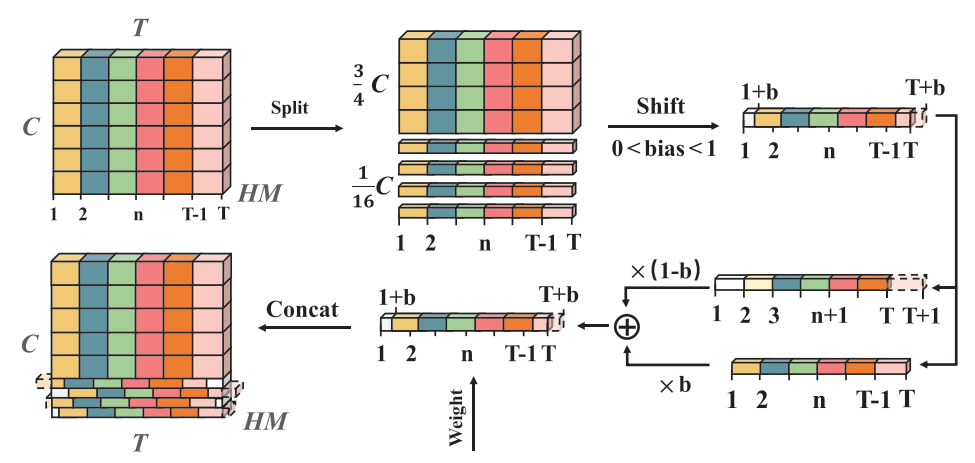

作者设计该模块是为了沿着时间维度shift特征图以融合时间信息到空间域上,作者将特征图的的通道进行移位,留下的通道不移位

Temporal-wise Frame Sampling:

此步骤主要是进行线性插值,最终所有的移动或者未移动的channel会串联得到特征图(与输入的特征图具有相等size)

其中,

Temporal Extension:小于0大于T+1的置零

Temporal Attention:特征图乘以权重之后再串联于,由于两端的特征被移出,会加入注意力机制来re-weight特征并更好的获取长期信息。

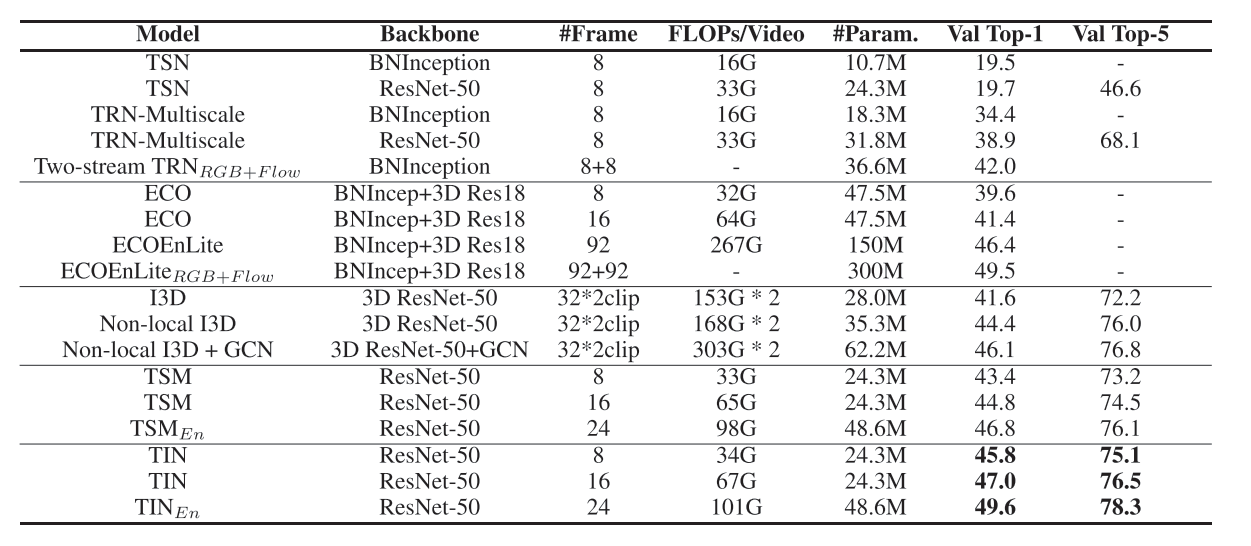

Experiment

在Something-something V1数据集上和其他方法的对比:

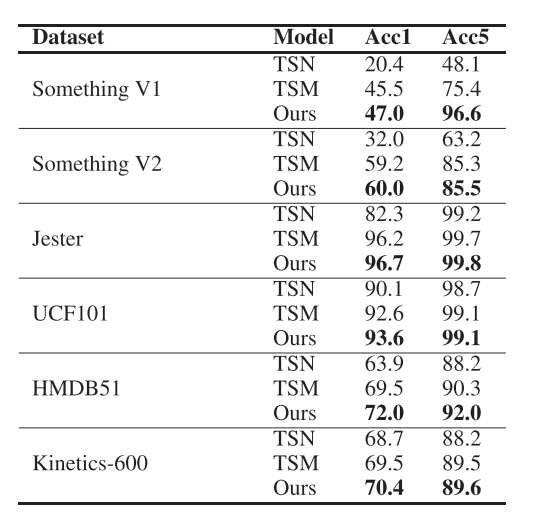

以ResNet-50为backbone比较TSN,TSM,TIN的效果:

参考:

Loading...